日前,神经信息处理系统大会(neurips 2019)于12月8日至14日在加拿大温哥华举行,程健研究员率队在本次大会的神经网络压缩与加速竞赛(micronet challenge)中获得双料冠军!

今年的micronet challenge神经网络压缩与加速竞赛由google、facebook、openai等机构在neurips2019上共同主办,集结了mit、kaist、华盛顿大学、浙大、北航等国内外著名前沿科研院校,同时还吸引了arm、ibm、高通、xilinx等国际一流芯片公司的参与。

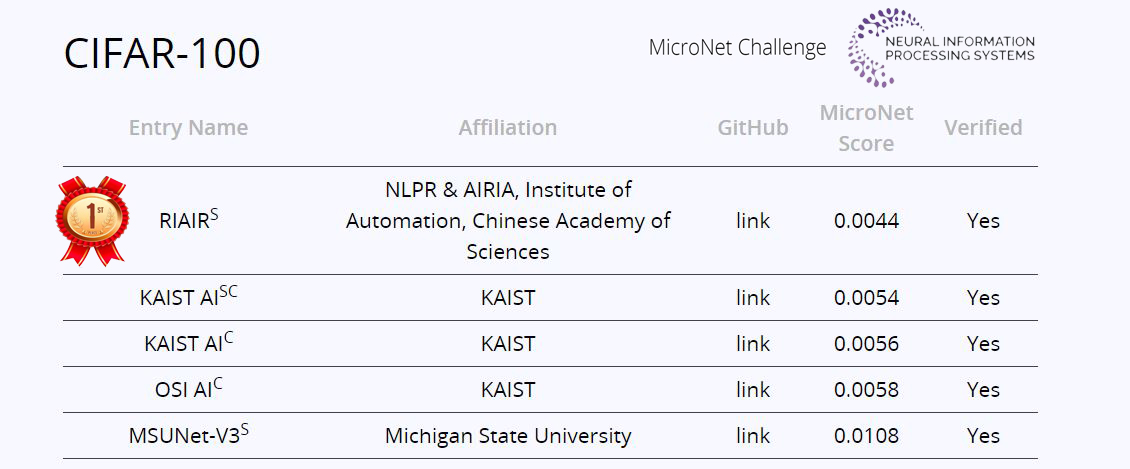

micronet challenge竞赛包括imagenet图像分类、cifar-100图像分类和wikitext-103语言模型三个子任务,以模型的压缩率和加速比的比拼为主要内容,目的是通过算法达到最优的运算效率,牵引更高效的神经网络处理器架构设计,并最终实现神经网络软、硬件加速的协同设计。程健研究员团队参加了竞争最激烈的imagenet和cifar-100两个子赛道比拼,并最终包揽了图像类的两项冠军。

团队结合极低比特量化技术和稀疏化技术,在imagenet任务上相比主办方提供的基准模型取得了20.2倍的压缩率和12.5倍的加速比,在cifar-100任务上取得了732.6倍的压缩率和356.5倍的加速比,遥遥领先两个任务中的第二名队伍。

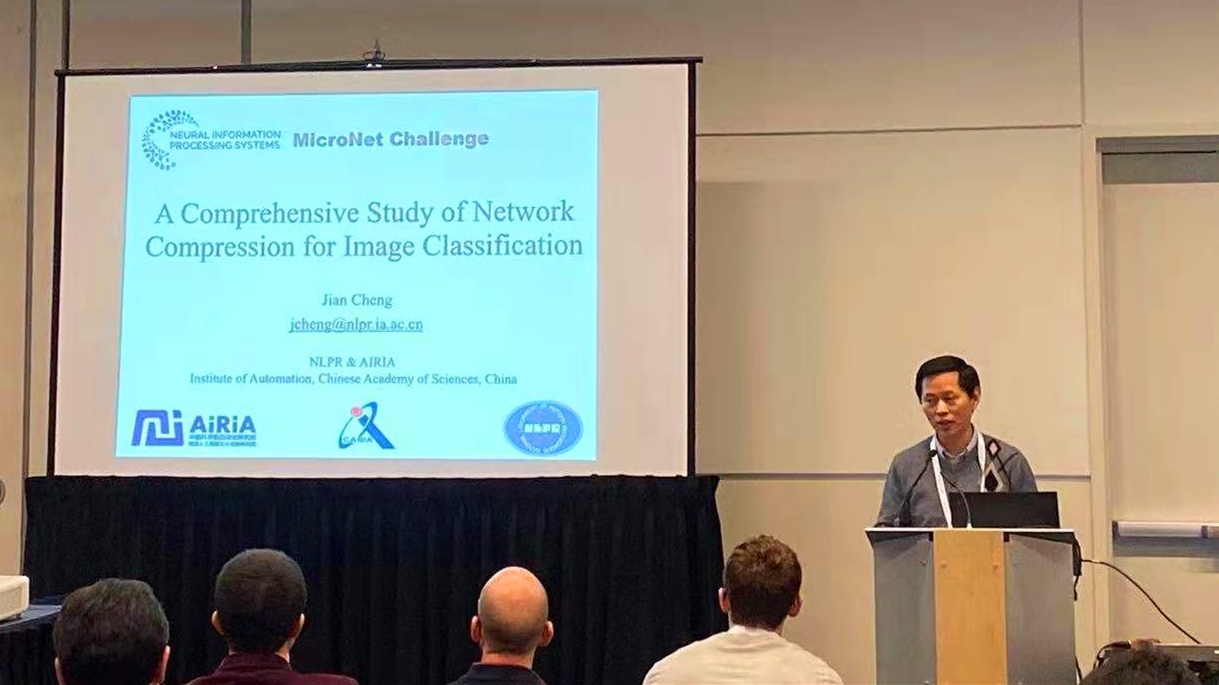

团队同时受邀在大会上以“a comprehensive study of network compression for image classification”为主题详细介绍了相关的量化和稀疏化压缩和加速技术。针对比赛任务,团队在报告中给出解决办法:采用量化和稀疏化技术,将深度学习算法模型进行轻量化和计算提速,以大幅降低算法模型对算力、功耗以及内存的需求,让低端设备实现人工智能方案。

团队成员冷聪副研究员表示,量化及稀疏化技术也是人工智能深度学习的软、硬件协同加速方案突破口。通过将其与人工智能硬件架构设计紧密结合,可以进一步降低人工智能技术落地难度,让ai更为易得易用。

|