近日,两年一度的计算机视觉大会iccv 2019(international conference on computer vision)在韩国首尔召开。iccv是全球人工智能顶级会议之一,联合举行的各项挑战赛是全球范围内计算机视觉领域最受关注和最权威的比赛。实验室共13篇文章入选iccv 2019,同时揽获7项竞赛大奖。

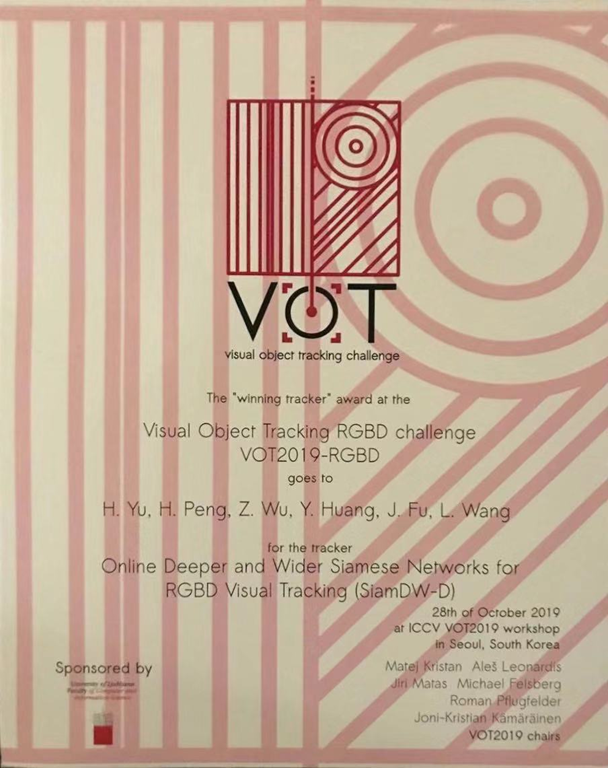

实验室智能感知与计算研究中心俞宏远联合微软亚洲研究院在vot2019-rgbd跟踪挑战赛中夺得了冠军。visual-object-tracking challenge (vot)是国际目标跟踪领域最权威的测评平台,旨在评测在复杂场景下单目标跟踪的算法性能。其中vot-rgbd竞赛所使用的数据集是目前国际公开数据集中挑战最大的rgbd跟踪数据集,该数据集中包含了跟踪目标形状变化、遮挡、消失后再出现以及黑暗环境下的目标跟踪等诸多挑战。我们使用的siamdw-d跟踪模型,融合了rgb和深度两种模态的数据,赋予了传统跟踪模型处理多种模态数据和在线更新的能力。因此,在跟踪过程中能更好地适应跟踪环境和跟踪目标的变化,实现了在复杂场景下的高精度鲁棒跟踪。

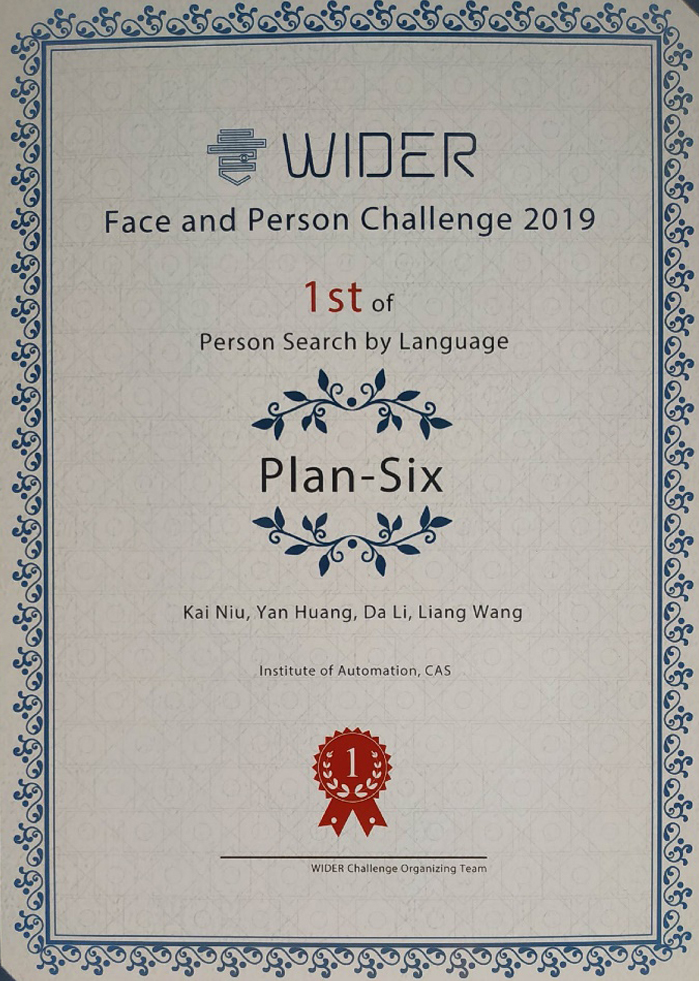

实验室智能感知与计算研究中心牛凯等人在wider face and person challenge 2019基于自然语言信息的行人检索person search by language任务中获得冠军。基于自然语言信息来检索大规模数据集中的行人图片是一项重要且极具挑战性的任务。在很多场景下,我们并不能得到可靠的待搜索对象的视觉信息。比赛所用测试数据与训练数据来自完全不同的真实监控场景,将该任务向实际应用推进了一大步,同时也对模型提出了更高的挑战。我们的模型不仅能够很好的处理自然语言和视觉信息间巨大的模态差异进行准确检索,同时能够克服真实监控场景下的跨领域难题,极大的提升了检索的准确性,在获得竞赛冠军的同时得分远超其他参赛队伍,在智能安防、零售、智慧城市等场景中均具有巨大的应用前景。

实验室生物识别与安全技术团队刘浩、朱翔昱、雷震等人在light weight face recognition challenge(lfr)大规模图像人脸识别赛道中获得冠军。经过近几年深度学习的发展,人脸识别技术已经在学术界众多人脸测试集上的性能达到饱和,但是在实际应用场景中仍有许多问题亟待解决,尤其是大规模人脸识别和视频人脸识别问题。iccv2019 light weight face recognition challenge(lfr)竞赛便是针对这些问题举办的人脸识别挑战赛。在大模型图像人脸识别赛道(deepglint-large)上,团队使用改进的se-attentionnet-ir作为基础架构,使用cosface作为损失函数并重点调整了margin,最终在有限的计算资源下战胜了众多参赛企业取得该赛道的冠军。并受邀到会议现场作题为“high performance face recognition without bells and whistles”的口头报告。

实验室视频内容安全团队张子琦、史雅雅、魏久桐、原春锋、李兵、胡卫明在视频描述竞赛vatex captioning challenge中获得中英文双料冠军。本次比赛由国际计算机视觉大会iccv和美国加州大学圣巴巴拉分校ucsb联合举办,分为中文描述和英文描述两个赛道。视频描述涉及到计算机视觉和自然语言处理两个领域,而且视频中有表观、运动、语义属性甚至语音等多个模态。因此如何更好地融合多模态信息,成为本次比赛的最大挑战。团队在没有大量样本训练的前提下,采取恰当的训练方式,依靠坚实的技术积累在中英文描述两个赛道均获冠军。

实验室图像与视频分析团队程健、冷聪、张一帆等在轻量级人脸识别比赛light weight face recognition challenge和快速人脸识别face detection runtime中分别获得亚军。light weight face recognition challenge和winder challenge face detection runtime challenge两项比赛是针对真实应用场景,在要求模型准确度同时,还分别重点关注模型的体积和检测速度。比赛所用数据集是目前国际公开的数据规模最大、真实度最贴近实际(数据来自真实场景)、检测难度最高的人脸识别检测数据集。我们的人脸识别模型,在模型精度、体积和速度上取得了突破,不但达到了高精度,还极大地降低了模型计算量和模型体积,实现了超高性能,在安防、金融、物联网等各种实际人脸识别场景,尤其在aiot边缘计算场景中有着广阔的应用潜力。

iccv 2019文章列表:

1.junran peng, ming sun, zhaoxiang zhang, tieniu tan and junjie yan, “pod: practical object detection with scale-sensitive network”

https://arxiv.org/abs/1909.02225

2.yanghao li, yuntao chen, naiyan wang, zhaoxiang zhang, “scale-aware trident networks for object detection”

https://arxiv.org/abs/1901.01892

3.haiping wu, yuntao chen, naiyan wang, zhaoxiang zhang, “sequence level semantics aggregation for video object detection”

https://arxiv.org/abs/1907.06390

4.chuanchen luo, yuntao chen, naiyan wang, zhaoxiang zhang, “spectral feature transformation for person re-identification”,

https://arxiv.org/abs/1811.114054

5.peipei li, xiang wu, yibo hu, ran he and zhenan sun, “m2fpa: a multi-yaw multi-pitch high-quality database and benchmark for facial pose analysis”

https://arxiv.org/abs/1904.00168

6.yan huang and liang wang, “acmm: aligned cross-modal memory for few-shot image and sentence matching”

http://openaccess.thecvf.com/content_iccv_2019/html/huang_acmm_aligned_cross-modal_memory_for_few-shot_image_and_sentence_matching_iccv_2019_paper.html

7.yong zhao, shibiao xu, shuhui bu, hongkai jiang, pengcheng han, “gslam: a general slam framework and benchmark”

https://arxiv.org/abs/1902.07995v1

8.wei feng, wenhao he, fei yin, xu-yao zhang, cheng-lin liu, “textdragon: an end-to-end framework for arbitrary shaped text spotting”

http://openaccess.thecvf.com/content_iccv_2019/papers/feng_textdragon_an_end-to-end_framework_for_arbitrary_shaped_text_spotting_iccv_2019_paper.pdf

9.yongcheng liu, bin fan, gaofeng meng, jiwen lu, shiming xiang, and chunhong pan, "densepoint: learning densely contextual representation for efficient point cloud processing"

https://arxiv.org/abs/1909.03669

10.chaoxu guo, bin fan, jie gu, qian zhang, shiming xiang, veronique prinet and chunhong pan, "psla: progressive sparse local attention for video object detection"

https://arxiv.org/abs/1903.09126

11.jun fu, jing liu, yuhang wang, yong li, yongjun bao, jinhui tang, hanqing lu, “adaptive context network for scene parsing”

http://openaccess.thecvf.com/content_iccv_2019/papers/fu_adaptive_context_network_for_scene_parsing_iccv_2019_paper.pdf

12.linyu zheng, ming tang, yingying chen, jinqiao wang, hanqing lu, “fast-deep kcf without boundary effect”

http://openaccess.thecvf.com/content_iccv_2019/html/zheng_fast-deepkcf_without_boundary_effect_iccv_2019_paper.html

13.jinlin wu, yang yang, hao liu, shengcai liao, zhen lei, stan z. li, unsupervised graph association for person re-identification

http://openaccess.thecvf.com/content_iccv_2019/html/wu_unsupervised_graph_association_for_person_re-identification_iccv_2019_paper.html

|